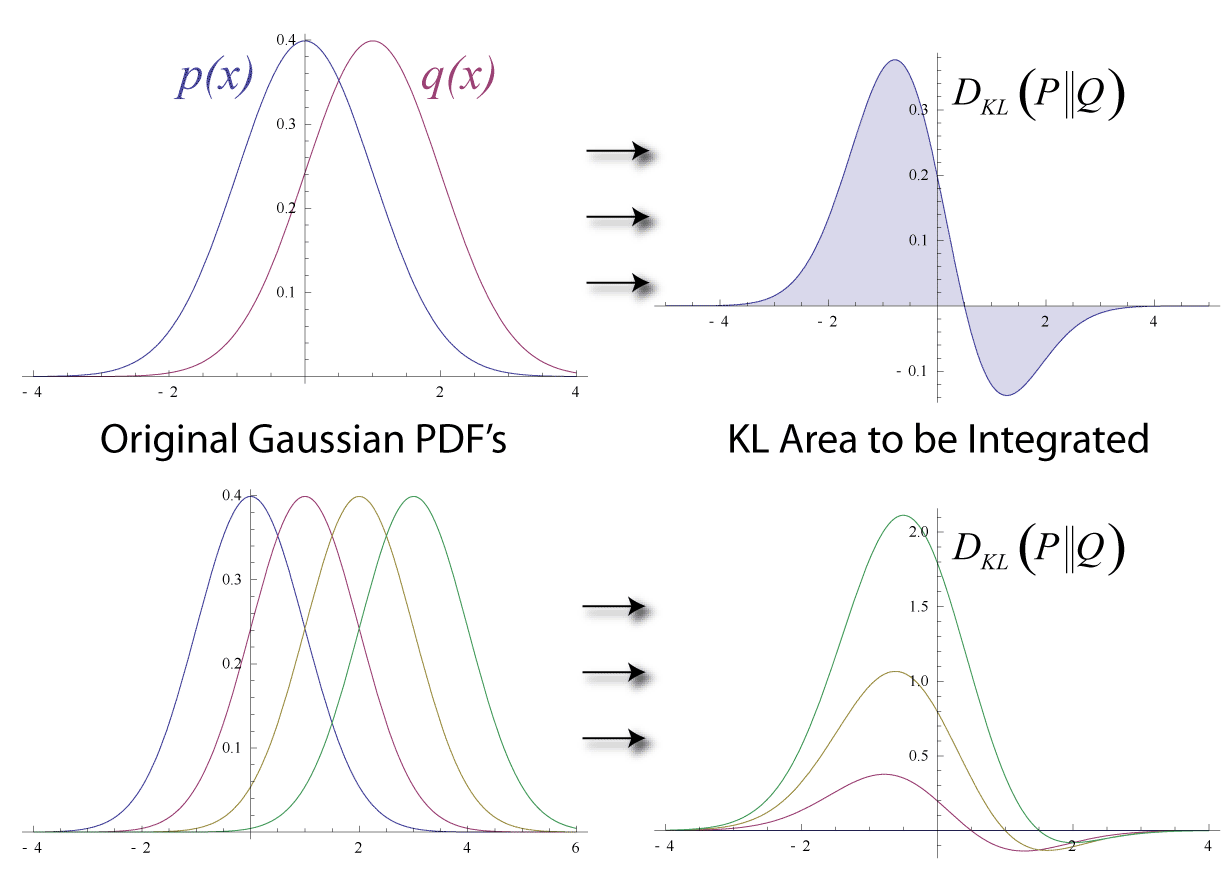

들어가며정보 이론과 통계학의 발전 과정에서 "두 확률 분포가 얼마나 다른가?" 라는 근본적인 질문에 대한 답을 찾기 위한 노력이 지속되었습니다. 1951년, 솔로몬 쿨백 (Solomon Kullback) 과 리처드 라이블러 (Richard Leibler)는 두 확률 분포 사이의 상대 엔트로피 (relative entropy), 즉 KL Divergence 를 제안하여 이 질문에 대한 획기적인 해답을 제시했습니다.KL Divergence 는 두 확률 분포 $P$ 와 $Q$ 의 차이를 측정하는 정보 이론적 척도입니다. $P$ 를 "기준 분포" 또는 "참 분포", $Q$ 를 "근사 분포" 또는 "모델 분포" 라고 할 때, $D_{KL}(P||Q)$ 는 $Q$ 로 $P$ 를 근사할 때 발생하는 정보량 손실, 또..