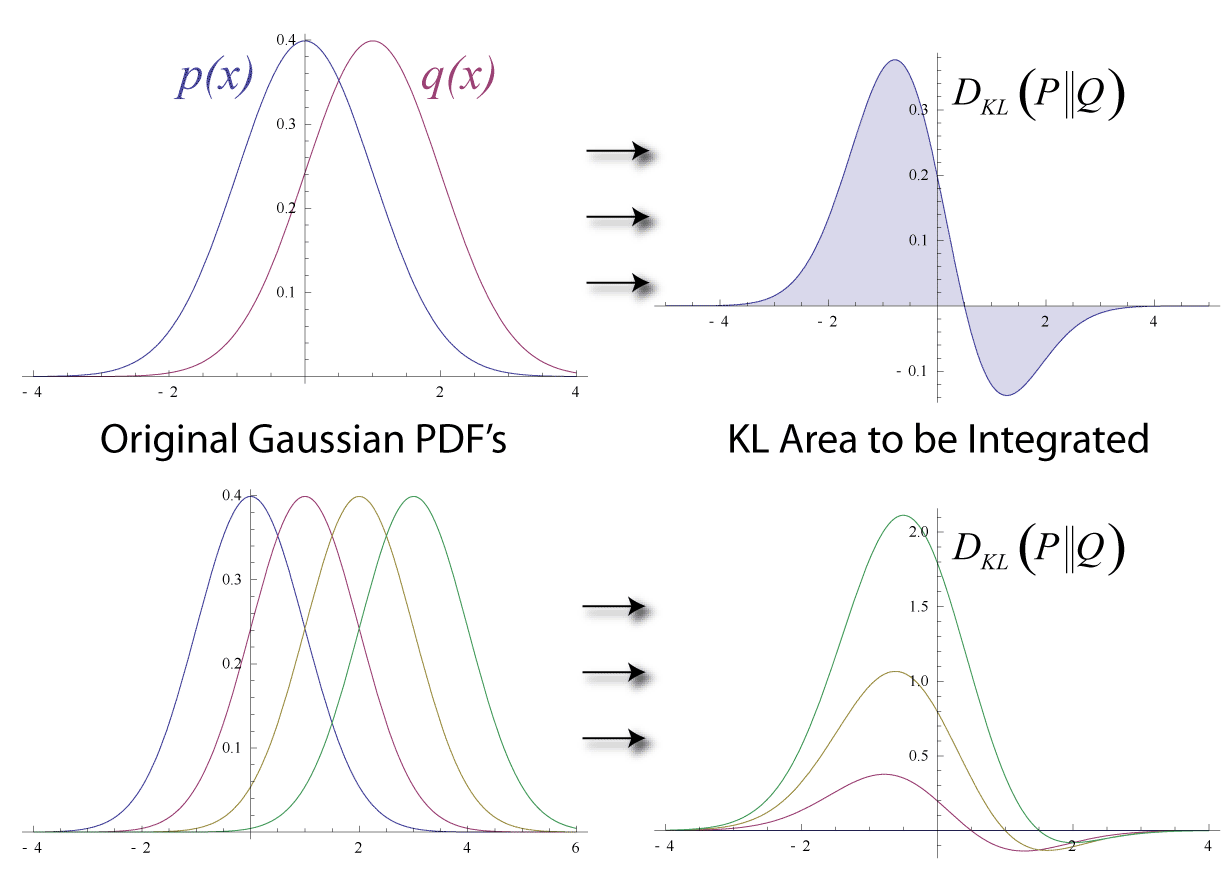

들어가며앞서 우리는 섀넌 엔트로피, 크로스 엔트로피, KL Divergence 를 통해 정보량, 불확실성, 그리고 확률 분포 간의 차이를 정량화하는 방법을 살펴보았습니다. 이제 정보 이론의 또 다른 핵심 개념인 상호 정보량 (Mutual Information, MI) 을 탐구하며, 두 확률 변수 사이의 상호 의존성 (mutual dependence) 또는 공유 정보량 (shared information) 을 측정하는 방법을 알아보겠습니다.Mutual Information 이란? - 변수 간의 관계성 측정일상 생활에서 우리는 종종 변수들 사이의 관계에 주목합니다. 예를 들어, "키가 클수록 몸무게가 많이 나갈 가능성이 높다" 거나, "날씨가 더울수록 아이스크림 판매량이 증가한다" 와 같은 경험적 관계를 인..